”learning rate“ 的搜索结果

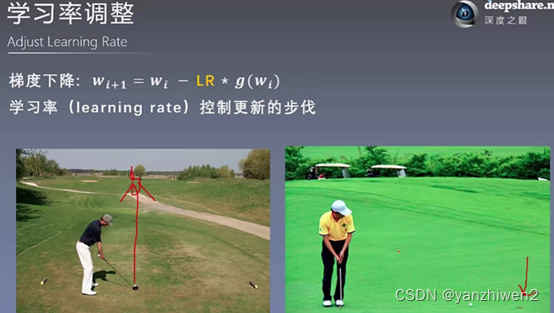

一、什么是学习率(learning rate) 二、学习率过小或过大的问题 三、学习率的设置 四、指数衰减法(exponential decay) 一、什么是学习率(learning rate): 学习率是指导我们该如何通过损失函数的梯度...

计算机视觉Github开源论文

【深度学习】学习率 (learning rate)

pytorch V1.60 提供了 10种 learning rate 调整方法,这里做一个简单的总结。 所有的学习率调整方法可以分3大类,分别是 有序调整,自适应调整,自定义调整。 第一类:有序调整,依据一定的规律有序进行调整,这一类...

The learning rate is perhaps the most important hyperparameter. If you have time to tune only one hyperparameter, tune the learning rate.\hspace{20em} – Page 429, Deep Learning, 2016 a l...

一、分段常数衰减 tf.train.piecewise_constan() 二、指数衰减 tf.train.exponential_decay() 三、自然指数衰减 tf.train.natural_exp_decay() 四、多项式衰减 tf.train.polynomial_decay() ...

1. 学习率对训练的影响为了能够使得梯度下降法有较好的性能,我们需要把学习率的值设定在合适的范围内。太大的学习速率导致学习的不稳定,太小值又导致极长的训练时间。自适应学习速率通过保证稳定训练的前提下,...

Time-Based Learning Rate Schedule Keras has a time-based learning rate schedule built in. The stochastic gradient descent optimization algorithm implementation in the SGD class has an argument calle...

1. 什么是学习率 调参的第一步是知道这个参数是什么,它的变化对模型有什么影响。 (1)要理解学习率是什么,首先得弄明白神经网络参数更新的机制-梯度下降+反向传播。... 总结一句话:将输出误差反向传播给网络参数...

本文主要挖一个关于「Equalized Learning Rate」的坑,后续再填。

文章目录分段常数衰减 tf.train.piecewise_constan...在使用优化算法的时候,我们都需要设置一个学习率(learning rate)。我这里总结了一些博主的方法。 学习率 的设置在训练模型的时候也是非常重要的,因为学习率...

Adaptive Learning Rate 一、问题描述 当分析训练的loss已经不会随着gradient的更新而变化时,不一定就是local minima或者saddle point,分析norm of gradient ,发现在loss几乎不变的时候,gradient 还在保持着较...

“微信公众号”1. 权重衰减(weight decay)L2正则化的目的就是为了让权重衰减到更小的值,在一定程度上减少模型过拟合的问题,所以权重衰减也叫L2正则化。1.1 L2正则化与权重衰减系数L2正则化就是在代价函数后面再...

目录 tensorflow中常用学习率更新策略 指数衰减 tf.train.exponential_decay() 分段常数衰减 tf.train.piecewise_constant() 多项式衰减tf.train.polynomial_decay() 自然指数衰减tf.train.natural_exp_decay()...

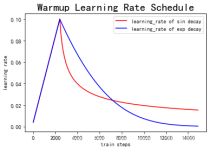

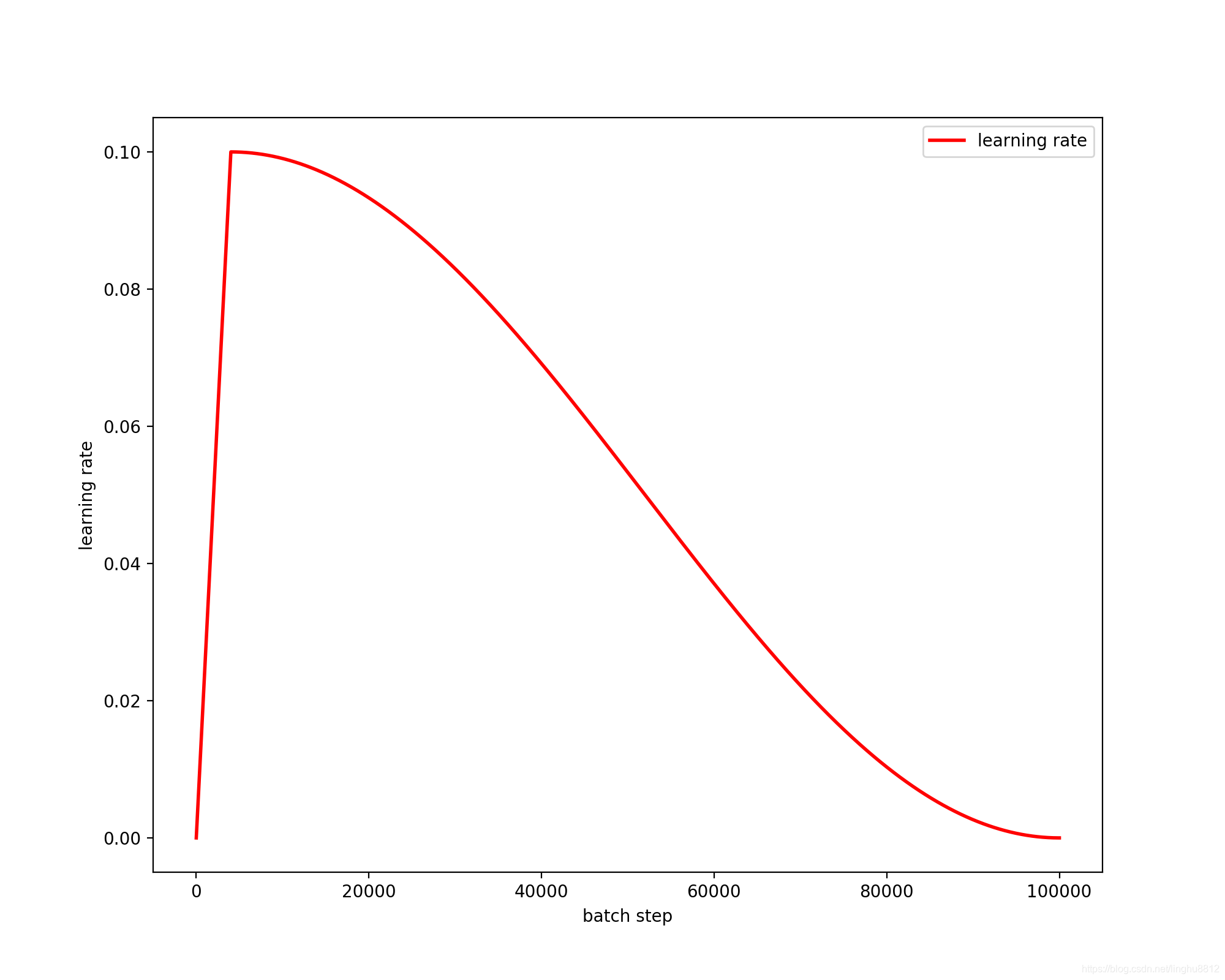

Cosine learning rate decay 学习率不断衰减是一个提高精度的好方法。其中有step decay和cosine decay等,前者是随着epoch增大学习率不断减去一个小的数,后者是让学习率随着训练过程曲线下降。 对于cosine decay,...

1.需要用到的库 设置学习率和模型 import math import matplotlib.pyplot as plt import torch.optim as optim from torchvision....lr_rate = 0.1 model = resnet18(num_classes=10) 2.LambdaLR实现cosine...

import torch.optim as optim optimizer = optim.Adam(net.parameters(), lr=1e-3, betas=(0.9, 0.99)) 在使用pytorch训练神经网络时,可能需要根据情况调整学习率(learning rate)

推荐文章

- C语言调用sqlite3命令语句实现将txt文件导入到数据库中_从txt导入到sqlite-程序员宅基地

- AOP与OOP有什么区别,谈谈AOP的原理是什么,大厂Android高级面试题汇总解答-程序员宅基地

- 最小费用流_单向图费用流-程序员宅基地

- Python中的5个高阶概念属性的知识点!你要了解明白哦!_python属性的五大类-程序员宅基地

- python 基于PHP+MySQL的装修网站的设计与实现_python抓取装修需求-程序员宅基地

- ubuntu完美的nvidia驱动安装方式(ubuntu16+驱动410+cuda10.0)or(ubuntu16+驱动455+cuda11.1)_乌班图英伟达驱动选着哪个版本-程序员宅基地

- 解决redis超时io.lettuce.core.RedisCommandTimeoutException: Connection timed out after 5s-程序员宅基地

- 基于OFDM+64QAM系统的载波同步matlab仿真,输出误码率,星座图,鉴相器,锁相环频率响应以及NCO等-程序员宅基地

- Springboot毕设项目超市商品销售管理系统37x2w(java+VUE+Mybatis+Maven+Mysql)_vue+springboot+mybatis商品管理系统-程序员宅基地

- 关掉\禁用win7自动配置ipv4地址的方法 默认网关自动消失的解决办法_禁止修改网关命令-程序员宅基地